这是一个创建于 562 天前的主题,其中的信息可能已经有所发展或是发生改变。

要能用户自己导入书籍 甚至可以导入很多本书,然后让它从所有这些书里找,能实现不?

第 1 条附言 2024-03-28 10:45:15 +08:00

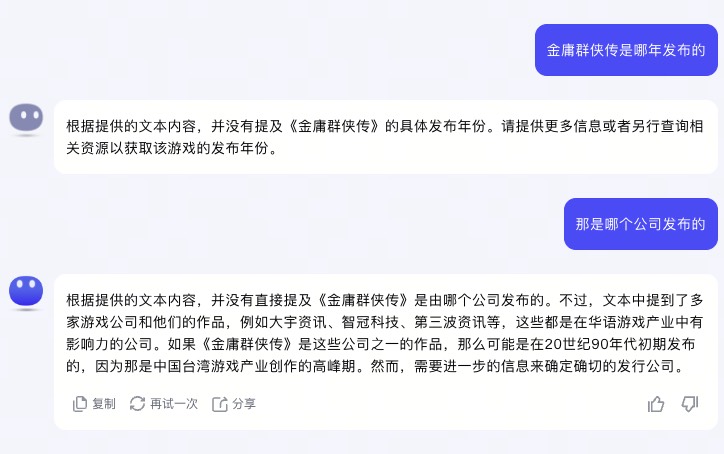

kimi 试了下感觉还是效果不大行 回答有很多错 即使是不需要上下文推理 人眼一看就知道的答案 如问它某个游戏是哪个公司发布的 文中就在一句话里写明了 XXX 公司的 XXX 游戏 也答不了

第 2 条附言 2024-03-28 10:51:25 +08:00

第 3 条附言 2024-04-26 18:16:42 +08:00

更新:

minimax 海螺 AI 能回答到上面那问题,当时没找到用户界面入口

2023 年就有很多人在用家用电脑跑本地 AI 了

minimax 海螺 AI 能回答到上面那问题,当时没找到用户界面入口

2023 年就有很多人在用家用电脑跑本地 AI 了

1 183387594 2024-03-27 15:59:38 +08:00 现在很多支持文档上传的 都支持了,kimi,minimax,讯飞 向量搜索+ai 解读 |

2 senlinmuvs OP @183387594 OK 谢谢 |

3 senlinmuvs OP |

4 183387594 2024-03-27 17:05:28 +08:00 @senlinmuvs 3l ,是的 有向量化的接口 可以本地做知识库 再结合他们的接口 |

5 senlinmuvs OP @183387594 要是有能完全在本地跑的就好了 就一个单机软件 导入 然后分析 |

6 MapleEve 2024-03-28 00:46:14 +08:00 @senlinmuvs 本地可以,训练千亿级大模型先准备几百万的设备就行。就算花钱云上微调训练也要大几千上万 |

7 senlinmuvs OP @MapleEve 把那些训练好的模型打包进单机软件 再用来分析固定的文本 就不需要这么复杂吧 |

8 MapleEve 2024-03-28 10:41:28 +08:00 @senlinmuvs 你先明白本地要跑起来训练好的模型需要多大的显存,然后再搞明白 finetune 需要多大的显存。本地不是不能跑,是你的电脑跑不了。 |

9 senlinmuvs OP @MapleEve 哦 那不了解 跑起来大概是要多大配置呢 |

10 ywkk 2024-03-28 14:39:21 +08:00 @senlinmuvs 你不了解,你以为打包的仅是这本书的内容,其实你需要打包的是理解这本书的大脑,也就是大模型本身,千亿大模型需要什么配置,你的本地化就需要什么配置。 |

11 senlinmuvs OP @ywkk 我说的就是打包大脑要多大配置呢 有固定场景的大脑应该比那些通用智能的大脑需要的应该是简化些的 现在没有 以后应该会出现 |

12 senlinmuvs OP @ywkk 那个啥文生图的不是就有本地的方案吗 |

13 MapleEve 2024-03-29 02:01:19 +08:00 @senlinmuvs 得了吧,什么都不懂,能跑得动千亿大模型的集群硬件成本就是大几百万。 本地能跑的那些都是玩具。 |

14 senlinmuvs OP @MapleEve 现在那些线上的不也是玩具 世界上第一台电脑还有房子那么大呢 |

15 MapleEve 2024-03-31 16:40:37 +08:00 via iPhone @senlinmuvs 是的你说得对,所以你去造一台出来吧 |

16 senlinmuvs OP |

17 senlinmuvs OP @MapleEve 看你博客了 啥都往网上放 |

18 MapleEve 2024-04-01 09:57:12 +08:00 @senlinmuvs 笑了,7B 模型有锤子用,Grok 跑起来要 200G 显存也是个垃圾。 你先看明白电脑跑 100B 模型要什么配置再说吧,什么都不懂,别人指出你的理解有问题还杠。 你说的都对,你自己去部署了试试吧。 |

19 senlinmuvs OP @MapleEve 行吧 想必你是想得这么个回复:“你厉害呢” |

20 ruike2 2024-04-01 14:08:40 +08:00 这就不得不提及这个 AI 工具网址大全了: https://aitool8.com/ |

21 MapleEve 2024-04-01 14:17:05 +08:00 @ruike2 太不全了,Claude 、PoE 、Openrouter 一类的没有,国内的深度求索、Kimi ,GLM4 也没有 贴主想要的就是白嫖那种几百万字知识库微调的模型,不过各大厂商也不是傻子,就算你用阿里云、智谱的微调训练,以几百万字来算的话,也是要几千块的。 |

22 senlinmuvs OP @ruike2 先收藏以备后用 |

24 mmdsun 2024-04-06 19:17:37 +08:00 via iPhone @MapleEve 这种就是 RAG 。书本地存向量数据库,提问先搜向量数据库,返回相似度高的结果喂给 AI 就行。本地完全可以。看好几个 v 友都是这么玩的。跑向量数据库不需要太好配置。 |

25 ruotongyu 170 天前 我开发过类似的工具,你这个用途是啥呢? |